战争期间,乌克兰持续袭击俄罗斯以及占领区内的防空设施。此类袭击的主要目标是防空导弹发射装置,以及移动式和固定式雷达。通过削弱俄罗斯防空力量,能够为乌克兰空军和远程打击无人机争取更大的作战空间。

乌克兰袭击罗斯托夫航空雷达

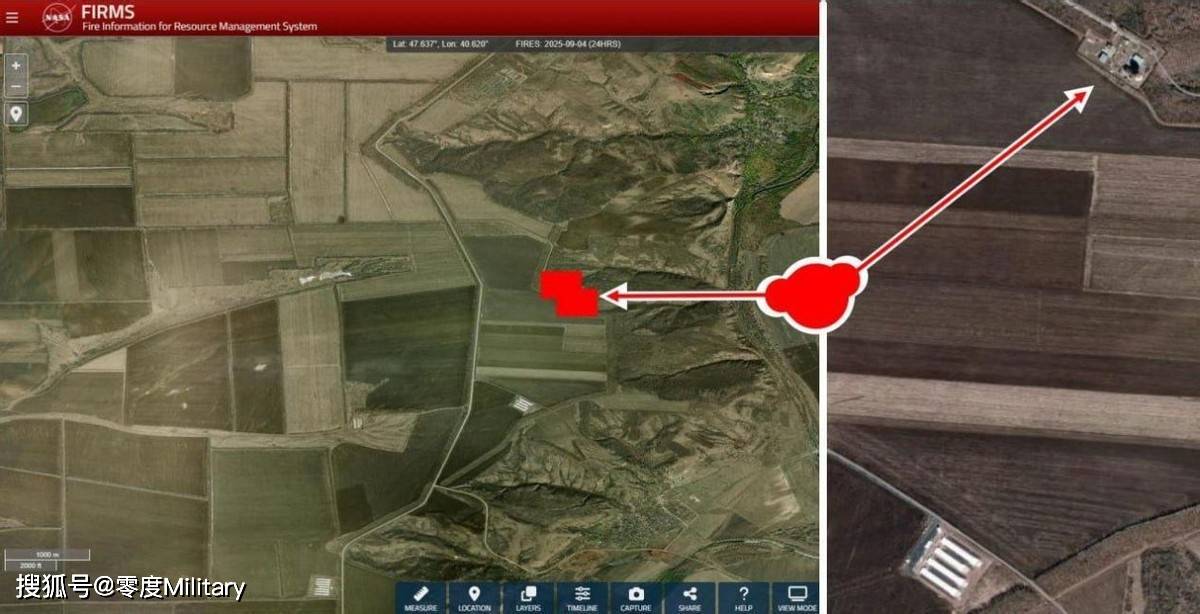

RLS-1“南方导航”雷达系统是顿河畔罗斯托夫南方航空导航分公司的基础设施,在俄罗斯南部地区空中交通管理中发挥着关键作用,包括飞机探测和跟踪、航线协调、飞行保障、航空无线电通信及卫星固定链路传输。

乌克兰电报频道“克里米亚之风”(Krymskyi Veter)称,9月4日这片区域发生了火灾。美国宇航局的地图也显示,这片区域探测到了热源信号,证实了火灾情况。

袭击还波及前防空基地

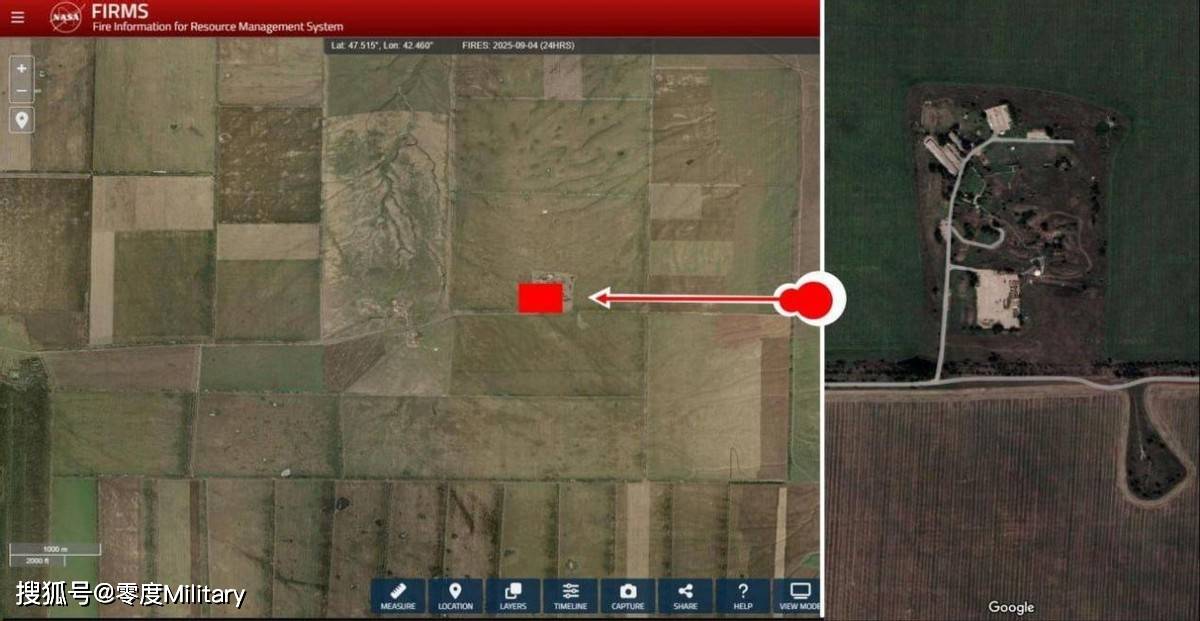

美国宇航局的数据还显示,第二个遇袭目标位于一个前防空部队(军事单位65312)和军事城镇的所在地。此地曾驻扎第1244防空导弹团,上世纪90年代配备S-300PS地对空导弹系统,1997年与第584团合并后迁往莫斯科州的马里诺基地。

《军事报》指出,俄罗斯很可能重启这座基地用于战争。现场部署有与RLS-1相似的雷达综合设施,据悉可以执行类似的任务。

8月克里米亚雷达袭击事件回顾

8月12日,乌克兰特种部队在被俄罗斯占领的克里米亚半岛摧毁了“斯卡拉-M”雷达站。这座雷达站用于沿航线和进近区的空中交通控制,探测范围可达350公里。

微信扫一扫打赏

微信扫一扫打赏

支付宝扫一扫打赏

支付宝扫一扫打赏